Einstellungen

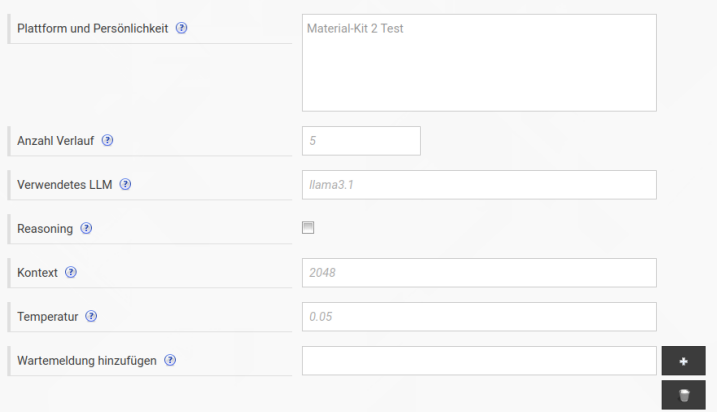

Plattform und Persönlichkeit

Der Chatbot gibt sich standardmäßig als "hilfreicher Assistent" für den aktuellen Mandanten aus. Dabei wird als Bezeichnung der eingestellte Mandanten Titel verwendet. Sie können stattdessen auch eine eigene Bezeichnung und Persönlichkeit für die verwendete Plattform einstellen.

Anzahl Verlauf

Jede Folge-Frage an den Chatbot sendet den bisherigen Verlauf an das LLM weiter (Standard: 5). So kann dieses den Kontext der bereits gestellten Fragen und gegebenen Antworten berücksichtigen. Auch der Verlauf zählt zur maximalen Kontext-Größe des LLM dazu. Dies gilt es zu beachten.

Verwendetes LLM

Falls Sie keine Ollama URL angeben, wird standardmäßig das ChatGPT Model gpt-4o verwendet. Mit dem Prefix openai: können Sie bei Bedarf auch das verwendete ChatGPT Model wechseln.

Geben Sie bei eingestellter Ollama URL hier die Bezeichnung des Models ein, das verwendet werden soll. Stellen Sie sicher, dass das Model in Ihrer Ollama Installation auch installiert ist.

Reasoning

Wenn es sich bei dem verwendeten Model um ein Reasoning Model handelt, dann muss diese Checkbox aktiviert werden, da Reasoning Models andere Parameter erwarten.

Kontext

Die maximale Anzahl an Tokens, die für den Kontext verwendet werden sollen.

Temperatur

Die Temperatur gibt einem LLM an, wie kreativ es bei seinen Antworten sein soll. Standardmäßig ist diese Kreativität im Chatbot sehr niedrig eingestellt. Falls Sie kreativere Antworten wünschen, geben Sie hier einen höheren Wert an. Der maximale Wert für die Temperatur hängt vom verwendeten Model ab.

Verbindung

Auf dem Reiter Verbindung können Sie die im Mandanten oder gobal definierten Daten zum Verbindungsaufbau mit dem eingestelltem LLM spezifisch für diesen Chatbot überschreiben.

Wartemeldung hinzufügen

Hier können Sie Texte hinterlegen, die automatisch angezeigt werden, wenn der Chatbot für das generieren einer Antwort mehr als 10 Sekunden benötigt.

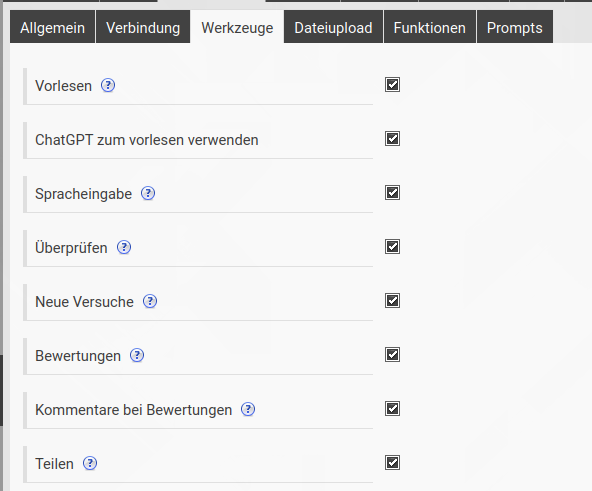

Werkzeuge

Am Ende der letzten Antwort stehen ggf. Werkzeuge zur Verfügung, die Sie hier aktivieren können. Diese Werkzeuge sind:

- Vorlesen: Die letzte Antwort wird vorgelesen.

- ChatGPT zum vorlesen verwenden: Die Audio-Datei zum Vorlesen wird per ChatGPT generiert.

- Spracheingabe: Fragen können per Text-to-Speech gestellt werden

- Überprüfen: Weist das LLM an seine letzte Antwort zu überprüfen

- Neue Versuche: Die letzte Antwort wird neu generiert.

- Bewertungen: Die letzte Antwort kann bewertet werden (positiv oder negativ).

- Kommentare bei Bewertungen: Beim Abgeben einer Bewertung kann optional ein Kommentar hinterlegt werden. Kommentare können auf dem Reiter "Verläufe" eingesehen werden.

- Teilen: Chatverläufe können geteilt werden

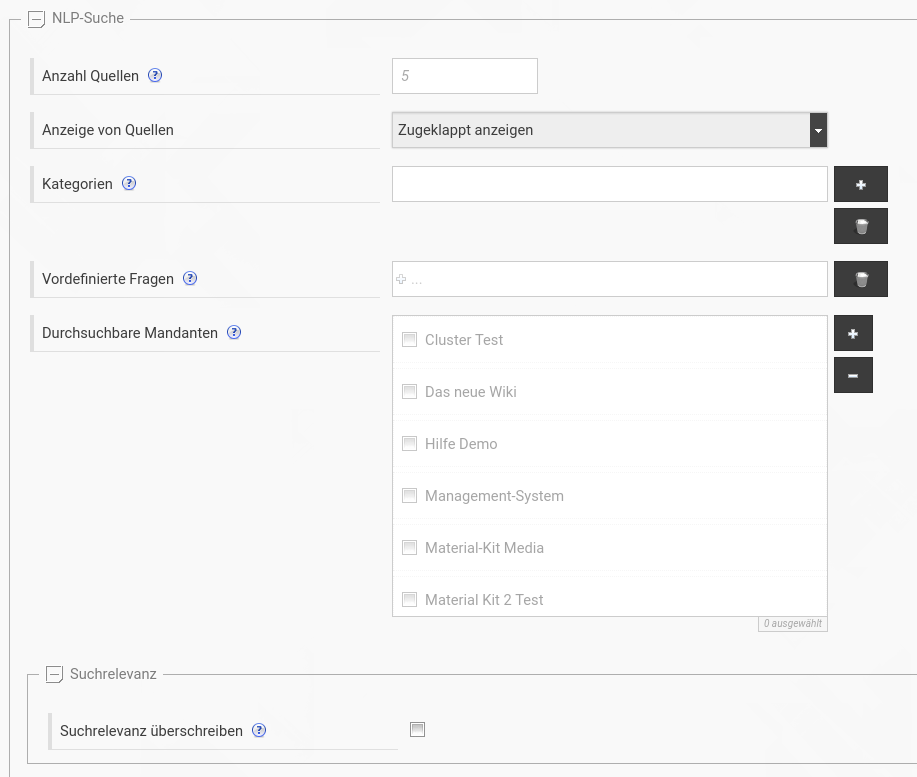

Anzahl Quellen

Die Anzahl der Quellen gibt an, wie viele Suchtreffer maximal für die Bereitstellung des Kontext verwendet werden sollen (Standard: 5). Bitte beachten Sie, dass die Größe des übergebenen Kontext an das LLM eine vom Model, bzw. Hardware, abhängige Obergrenze hat. Zu viel Kontext kann das LLM dazu verleiten, diesen zu ignorieren. Empfohlen werden deshalb möglichst wenig Quellen. Ihre Inhalte sollten ausführlich und vollständig sein.

Anzeige von Quellen

Über diese Einstellung können Sie entscheiden, wie der Chatbot seine Quellen darstellt.

Kategorien

Standardmäßig durchsucht der Chatbot alle Seiten des Mandanten. Sie können hier zusätzlich bestimmte Seiten als Kategorien auswählen, welche vor dem Start einer Unterhaltung mit dem Chatbot ausgewählt werden können. Dies geschieht in Form einer Auswahlliste. Ist eine Kategorie ausgewählt, werden nur die Seiten unterhalb dieser Seite für die Unterhaltung berücksichtigt.

Sie können über die Checkbox Unterseiten festlegen, dass nicht die ausgewählte Seite als Kategorie zur Verfügung steht, sondern stattdessen die direkten Unterseiten dieser Seite.

Vordefinierte Fragen

Geben Sie vordefinierte Fragen an, die Ihre Benutzer dem Chatbot optional stellen können. Das Eingabefeld für die eingehende Frage wird dabei um eine entsprechende Auswahlliste erweitert.

Durchsuchbare Mandanten

Standardmäßig durchsucht der Chabot nur die Seiten des aktuellen Mandanten. Sie können stattdessen auch mehrere Mandanten auswählen, in denen gesucht werden soll.

Suchrelevanz

Standardmäßig verwendet der Chatbot die eingestellte Suchrelevanz des aktuellen Mandanten für die Felder Schlagwörter, Name, Titel, Kurzbeschreibung und Inhalt. Bei Bedarf können Sie diese Einstellungen für den Chatbot überschreiben.

Es wird empfohlen für die Suchrelevanz den Inhalt immer am höchsten zu bewerten.

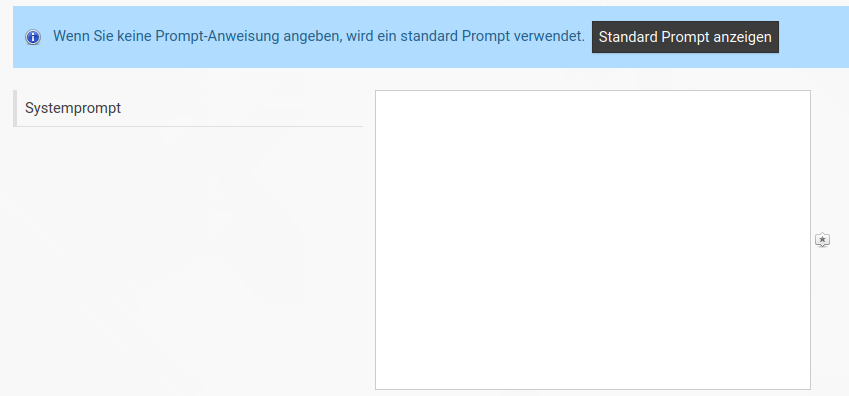

Prompt-Anweisungen

Der Chatbot verwendet standardmäßig einen ausgearbeiteten System Prompt, um das Verhalten des LLM zu steuern. Sie können bei Bedarf diesen Prompt vollständig überschreiben.

Für Ihren Prompt stehen mehrere Platzhalter zur Verfügung, die Sie in integrieren sollten. Dies sind:

- {platform}: Der Name der Plattform.

- {context}: Der übergebene Inhalt aller Quellen als Kontext.

- {query}: Der eingegebene Text vom Benutzer. Dieser Platzhalter ist optional, da der eingegebene Text immer in der automatisch bereitgestellten Historie steht.